摘要:本文探讨了大型语言模型中出现的胡话与幻觉现象的原因,分析了模型训练过程中的数据偏差、过度拟合等问题。文章还探讨了解决方案,包括改进数据预处理、增加模型多样性、优化训练策略等。通过深入研究和实践,旨在提高大模型的性能和准确性,减少胡话与幻觉的产生。

本文目录导读:

近年来,随着人工智能技术的飞速发展,大模型在众多领域展现出了强大的能力,大模型在实际应用中出现的“说胡话”现象,引发了广泛关注,这种现象不仅影响了模型的准确性和可靠性,也限制了其在实际场景的应用,本文将探讨为什么大模型会“说胡话”,并提出解决大模型的“幻觉”问题的策略。

大模型为什么会“说胡话”

1、数据质量问题

大模型的训练需要大量的数据,而数据的真实性和多样性直接影响模型的性能,当训练数据存在噪声、错误或偏差时,模型可能学习到错误的信息,从而导致输出结果的准确性下降,数据质量问题是大模型出现“胡话”现象的重要原因之一。

2、模型复杂性过高

为了应对复杂的任务,大模型通常具有庞大的参数数量和复杂的结构,这种复杂性使得模型在训练过程中容易出现过拟合现象,即模型过于适应训练数据,而对未知数据的适应能力下降,过拟合现象可能导致模型在预测时出现错误,从而表现出“说胡话”的行为。

3、缺乏可解释性

大模型通常具有高度的黑盒性,其决策过程难以解释,这使得我们难以确定模型出现错误的原因,也无法对模型进行有效的调整和优化,缺乏可解释性可能导致模型在实际应用中出现不可预测的行为,从而引发“说胡话”的问题。

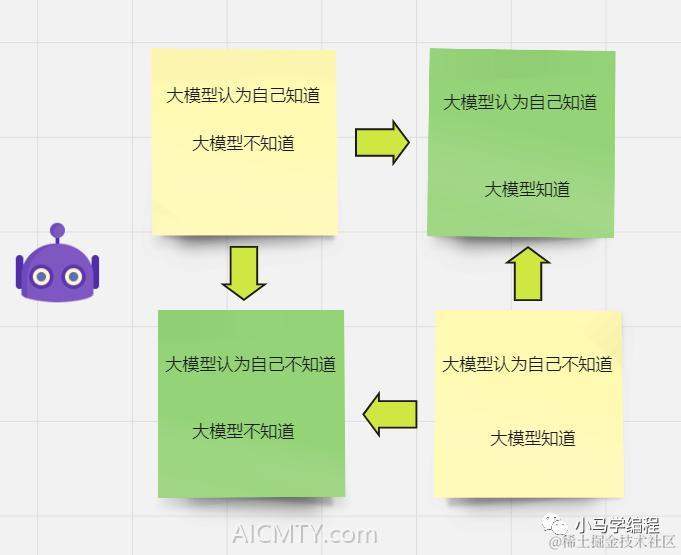

大模型的“幻觉”问题解析

大模型的“幻觉”问题主要是指模型在特定情境下产生的误导性输出,这种幻觉可能源于模型对数据的误解、对任务的错误理解等方面,与“说胡话”现象相似,“幻觉”问题同样会影响模型的准确性和可靠性。

解决大模型的“说胡话”与“幻觉”问题

针对大模型出现的“说胡话”和“幻觉”问题,我们可以从以下几个方面着手解决:

1、提高数据质量

提高训练数据的质量是解决大模型“说胡话”问题的关键,我们需要对训练数据进行严格的筛选和预处理,去除噪声、错误和偏差,还可以采用数据增强技术,通过生成更多的训练样本,提高模型的泛化能力。

2、改进模型结构

为了降低大模型的复杂性,我们可以优化模型的结构和参数,采用更高效的模型架构、使用参数剪枝技术等方法,降低模型的复杂度,从而减少过拟合现象的发生。

3、增强模型的可解释性

增强模型的可解释性有助于我们更好地理解模型的决策过程,从而发现和解决模型的问题,我们可以通过采用可视化技术、引入注意力机制等方法,提高模型的可解释性,还可以借助一些可视化工具,对模型的内部表示进行分析和调试。

4、采用集成学习方法

集成学习方法是一种通过结合多个模型的预测结果来提高模型性能的方法,我们可以采用集成学习方法,将多个大模型的预测结果进行融合,从而提高模型的准确性和稳定性,集成学习方法还可以帮助我们发现单个模型的问题,从而进行针对性的优化。

5、加强模型验证与调试

在模型训练过程中,我们需要加强模型的验证与调试,通过对比模型的预测结果与真实结果,发现模型的误差来源,还可以采用一些调试技术,如温度缩放、梯度裁剪等,对模型进行优化和调整。

大模型的“说胡话”和“幻觉”问题已经成为制约其应用和发展的关键因素,为了解决这些问题,我们需要从提高数据质量、改进模型结构、增强可解释性、采用集成学习方法和加强模型验证与调试等方面着手,随着技术的不断进步和研究的深入,我们有信心克服这些挑战,推动大模型在实际场景中的广泛应用。

京ICP备11000001号

京ICP备11000001号